Comfy-WaveSpeed加速节点FLUX和混元都可以使用

官方地址:https://github.com/chengzeyi/Comfy-WaveSpeed

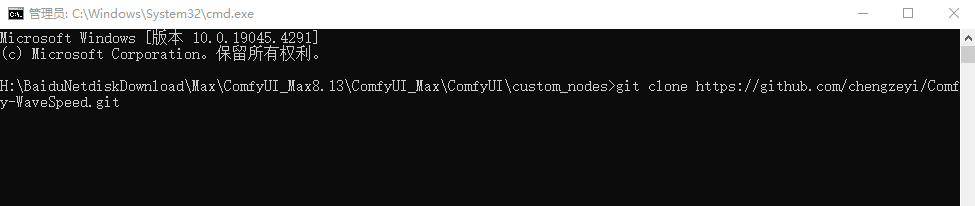

安装:custom_nodes目录下输入CMD然后输入:git clone https://github.com/chengzeyi/Comfy-WaveSpeed.git

ComfyUI 的多合一推理优化解决方案,通用、灵活、快速。

受TeaCache和其他去噪缓存算法的启发,我们引入了第一块缓存(FBCache),以使用第一个变压器块的剩余输出作为缓存指示符。如果第一个 Transformer 块的当前残差输出与之前的残差输出之间的差异足够小,我们可以重用之前的最终残差输出并跳过所有后续 Transformer 块的计算。这可以显着降低模型的计算成本,在保持高精度的同时实现高达 2 倍的加速。

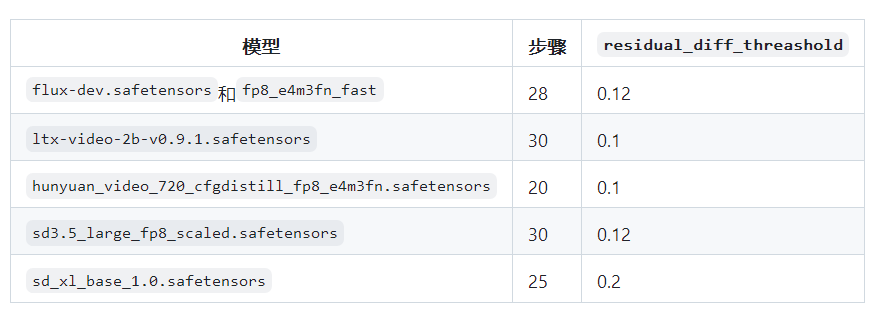

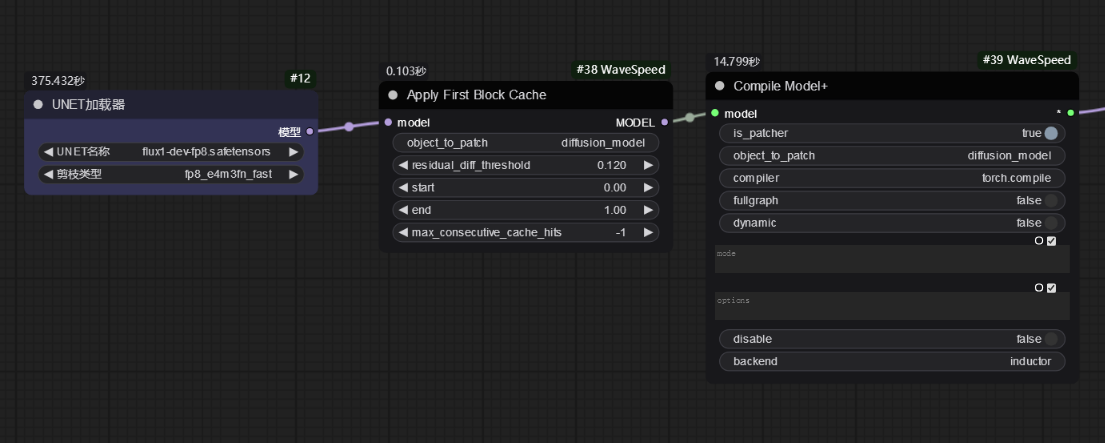

要使用第一个块缓存,只需在节点wavespeed->Apply First Block Cache之后将节点添加到工作流中Load Diffusion Model,并将值调整residual_diff_threashold为适合模型的值,例如:0.12for flux-dev.safetensorswithfp8_e4m3fn_fast和 28 步骤。预计速度将提高 1.5 倍至 3.0 倍,并且精度损失可接受。

FLUX它支持、LTXV (native and non-native)、HunyuanVideo (native)、SD3.5等多种型号SDXL,请随时尝试

您可以尝试针对不同型号的一些配置:

注意:SDXL 第一块缓存与FreeU Advanced节点包不兼容,如果安装并启用它,将无法正常工作。

这个插件第二次速度就会快很多,速度将提高 1.5 倍至 3.0 倍

工作流地址:https://pan.quark.cn/s/c6cf1d32d52a

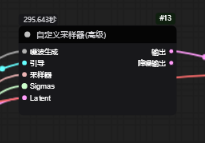

第一次运行295秒

第二次110秒

第三次29秒

第4次24秒